Blog

Dernières entrées

Cette section est un lieu d'expression des membres de l'association sur des actualités ou des sujets qui leur tiennent à cœur.

Traduction : "La valeur de la décentralisation dans la science"

Ce billet est une traduction de l'article d'opinion “The Value of Decentralization in Science” de Jakob Schwichtenberg, que j'ai trouvé intéressant pour les réflexions à différents niveaux qu'il suscite, notamment sur l'importance de valoriser aussi les petits projets, sur le questionnement de nos envies de projets “grandioses” ou sur l'importance de diversifier nos indicateurs pour juger l'intérêt d'un projet. Vous trouverez ci-dessous une traduction libre.

Actuellement, l'avenir de la physique des particules est très incertain. Jusqu'ici, aucune découverte surprenante n'a été faite au LHC et personne ne sait avec certitude quelle est la meilleure solution. Est-ce qu'un autre collisionneur géant, encore plus grand que le LHC1), nous apporterait enfin les informations expérimentales dont nous avons tant besoin et qui nous aideraient à trouver la bonne théorie au-delà du modèle standard ? Ou est-ce que l'argent serait mieux investi dans de petits projets ?

Dans un nouvel essai intéressant, Adam Falkowski (bien connu pour son blog Résonaances) traite précisément de cette question. Il conclut :

Mettre l'accent sur des expériences de précision plutôt que sur des collisionneurs à haute énergie pourrait être le moyen le plus efficace de poursuivre l'exploration des interactions fondamentales dans les décennies à venir. Cela pourrait même permettre à la physique des particules de sortir plus forte de sa crise actuelle.

Ses conclusions et ses arguments m'ont immédiatement rappelé un essai beaucoup plus ancien intitulé “Six précautions à prendre par les scientifiques” de Freeman Dyson, publié dans “From Eros to Gaia”. L'essai date de 1988, mais il est étonnamment pertinent.

Dyson compare six situations où les gens devaient choisir entre :

- Un plan A qui consiste en plusieurs petits projets ;

- Un plan B qui consiste en un grand projet.

Sa principale conclusion est que dans la plupart des situations, le “Plan A” est la meilleure option.

Un exemple pertinent de son propos est lorsque “la communauté des biologistes moléculaires aux États-Unis se débat avec la question de savoir s'il faut mettre en place un grand projet pour cartographier et séquencer le génome humain, l'ensemble des trois milliards de paires de bases dans les gènes d'un être humain”. Ils avaient la possibilité de “mettre en place une installation de séquençage à l'échelle industrielle et visaient à ce que l'ensemble du travail soit effectué par une armée de techniciens en quelques années”. En plus du projet de séquençage, il y aurait également un grand projet de cartographie centralisé, utilisant les données de séquençage pour identifier tous les gènes humains connus et inconnus avec des endroits précisément connus dans le génome. Ce plan B nécessiterait une nouvelle dépense importante de fonds publics, avec les problèmes habituels qui en découlent, à savoir décider qui doit administrer les fonds et qui doit les recevoir“.

L'autre option consisterait à “poursuivre autant que possible la manière actuelle de procéder, avec des activités de cartographie et de séquençage menées de manière décentralisée par de nombreux groupes de scientifiques étudiant des problèmes particuliers de la génétique humaine. Dans le plan A, il n'y aurait pas de grand projet centralisé, ni d'effort pour séquencer les 3 milliards de bases du génome humain dans leur intégralité, quelle que soit leur importance génétique”.

Il fait ensuite valoir que le plan A est la bien meilleure option :

La séquence complète devrait être réalisée lorsque, et seulement lorsque, nous aurons développé la technologie permettant de faire le travail à moindre coût et rapidement. Lorsque cela peut être fait à moindre coût, allez-y et faites-le.

De plus, il conclut que le plan A serait intelligent :

Pour rester flexible et éviter de s'engager prématurément dans des programmes rigides. […] Malheureusement, dans l'histoire des comités de planification des programmes scientifiques, une telle sagesse est rare.

Au lieu d'investir une grande partie du budget disponible dans un seul grand projet, affirme-t-il, il est plus logique de répartir la même somme d'argent dans des projets plus petits. Ces petits projets permettront de développer davantage la technologie nécessaire et de réduire le coût des expériences. Après quelques années, il sera probablement possible d'obtenir les mêmes résultats pour des millions au lieu de milliards. De plus, il y a beaucoup plus de flexibilité et de possibilités pour laisser la place à des découvertes surprenantes.

Les arguments de Dyson contre les plans B sont encore plus convaincants et pertinents pour la question de savoir s'il faut construire un nouveau collisionneur géant lorsqu'il parle du SSC2).

Le SSC est un exemple extrême du Plan B. La question que nous devons nous poser est de savoir si le SSC est un bon Plan B comme le Very Large Array ou un Plan B désastreux comme Zelentchoukskaïa. […] Je ne prétends pas être infaillible quand je fais des suppositions sur l'avenir. Mais le SSC présente tous les symptômes caractéristiques d'un mauvais plan B. Il est mauvais sur le plan politique parce qu'il est poussé par des intérêts économiques et par des considérations de prestige national qui n'ont pas grand-chose à voir avec la valeur scientifique. Il est mauvais sur le plan éducatif parce qu'il verse de l'argent dans un projet qui offre peu de possibilités de participation créative des étudiants. Elle est mauvaise sur le plan scientifique parce que les collisions proton-proton qu'elle produit sont particulièrement difficiles à interpréter. Elle est mauvaise sur le plan écologique parce qu'elle écarte d'autres pistes de recherche susceptibles de déboucher sur des accélérateurs à haute énergie plus rentables. Aucun de ces arguments n'est concluant en soi, mais ensemble, ils constituent un argument solide contre le SSC. Il existe un risque sérieux que le SSC soit un recul aussi important pour la physique des particules que l'Observatoire de Zelentchoukskaïa l'a été pour l'astronomie.

Lorsque je discute de ces craintes avec mes amis physiciens des particules, certains appartenant à l'HEPAP et d'autres non, ils disent généralement des choses du style : “mais regardez, nous n'avons pas d'alternative. Si nous voulons voir le boson de Higgs, ou le quark top, ou le photino, ou toute autre nouvelle particule allant au-delà du Modèle standard, nous devons aller vers une énergie plus élevée. C'est soit le SSC, soit rien”. C'est le même genre de discours que vous entendez toujours lorsque d'aucuns plaident en faveur du plan B. C'est soit le plan B, soit rien. Cet argument prévaut généralement parce que le plan B est un élément grandiose, alors que le plan A est une collection de petits éléments. Lorsque vos yeux sont aveuglés par les paillettes d'un grand projet, toutes les petites actions semblent faire pâle figure en comparaison. […] Mais pour répondre aux physiciens qui disent “SSC ou rien”, nous devons produire une alternative pratique au SSC. Nous devons avoir un plan A. Le plan A ne signifie pas que nous devons renoncer à la physique des hautes énergies. Il ne signifie pas que nous devons arrêter de construire de grands accélérateurs. Il ne signifie pas que nous nous désintéressons des bosons de Higgs et des quarks top. Mon plan A ressemble plutôt au plan recommandé par le comité Alberts. Il dit : investissons davantage dans l'exploration de nouvelles idées pour construire des accélérateurs rentables. […] Mesurons la valeur d'un accélérateur par l'étendue des connaissances scientifiques qui sont produites pour le faire fonctionner, plutôt que par son énergie. Et pendant que la technologie pour consruire des accélérateurs moins chers et plus performants est développée, investissons plus d'argent dans l'utilisation efficace des accélérateurs que nous avons déjà.

Les partisans du SSC parlent souvent comme si l'univers était unidimensionnel, avec l'énergie comme seule dimension3). Soit vous avez l'énergie la plus élevée, soit vous n'avez rien. Mais en fait, le monde de la physique des particules est tridimensionnel. Ces trois “dimensions” d'une expérience de physique des particules sont l'énergie, la précision et la rareté. L'énergie et la précision ont des significations évidentes. L'énergie est principalement déterminée par l'accélérateur et la précision l'est principalement par le matériel de détection. La rareté désigne la fraction des collisions de particules qui produisent le processus particulier que l'expérience est destinée à étudier. Pour observer des événements très rares, nous avons besoin d'un accélérateur à haute intensité pour effectuer un grand nombre de collisions, et nous avons également besoin d'un détecteur avec une bonne luminosité et de bons algorithmes pour distinguer les événements rares du bruit de fond. Je ne nie pas que l'énergie soit importante. Construisons donc des accélérateurs de plus haute énergie quand nous pouvons le faire de manière rentable, mais gardons à l'esprit que l'énergie n'est pas la seule variable importante.

[…]

Mon plan A pour l'avenir de la physique des particules est un programme qui accorde une importance à peu près égale aux trois “dimensions”. Le plan A doit être un programme d'une flexibilité maximale, encourageant l'exploitation de nouveaux outils et de nouvelles découvertes où qu'elles se produisent. Encourager les travaux sur la précision signifie continuer à déployer des efforts importants pour mettre au point de nouveaux détecteurs à utiliser avec les accélérateurs existants. Encourager les travaux sur la rareté signifie construire de nouveaux accélérateurs qui donnent une forte intensité de particules à une énergie modérée. Une fois ces besoins satisfaits, le plan A comprendra encore de gros efforts pour avancer sur l'énergie. Toutefois, le principe directeur devrait être le suivant : davantage d'argent pour les expériences et moins pour la construction. Découvrons comment explorer un niveau d'énergie donnée sans être dispendieux avant de nous engager dans un colossal projet de construction.

Suivons le bon exemple du comité Alberts quand il dit : “Parce que la technologie requise pour atteindre la plupart des objectifs du projet [de séquençage le génome humain] nécessite une amélioration majeure, le comité recommande spécifiquement de ne pas établir un ou quelques grands centres de séquençage pour le moment”.

La conclusion tirée est cette réflexion :

Le plan A consiste en un mélange de nombreux programmes différents, à la recherche d'opportunités pour faire de la science remarquable sur les trois “dimensions”. Le plan A n'a pas la grande simplicité et la prévisibilité du SSC. Et c'est à mon avis la principale raison pour laquelle je préfère le plan A. Il n'y a pas d'illusion plus dangereuse que la croyance que le progrès de la science est prévisible. Si vous cherchez les secrets de la nature dans une seule direction, vous risquez de passer à côté des secrets les plus importants, ceux que vous n'aviez pas assez d'imagination pour prévoir.

Conférence en ligne sur l'ingénierie écologique

La cité des Sciences et de l'Industrie a invité Luc Abbadie, directeur du laboratoire Biogéochimie et écologie des milieux continentaux, pour parler du sujet de l'ingénierie écologique. Le lien est disponible ici : L’ingénierie écologique pour réparer ou améliorer les écosystèmes.

J'ai été agréablement surprise par cette conférence, qui permet de prendre du recul sur l'écologie scientifique en elle même. De nombreux termes que l'on entend de plus en plus sans vraiment savoir quoi mettre derrière sont expliqués. Ils sont aussi remis dans le contexte de leur apparition avec une approche historique.

- Les enjeux de viabilité et d'habitabilité de la Terre sont rappelés.

- Il cite des exemples d'approches législatives (Clean Water Act) et des évaluations économiques qui ont permis d'aller vers des solutions “basées sur la nature” plutôt que sur les solutions technologiques classiques.

- Ces solutions dites basées sur la nature s'inspirent des mécanismes qui gouvernent spontanément les écosystèmes : l'auto-organisation, la diversité de structures hétérogènes, et une certaine résilience.

- Il incite à rester vigilant car le vivant peut vite impacter de très grandes surfaces. Une mauvaise idée peut conduire à des catastrophes.

- En effet, l'écologie est une discipline complexe avec son approche systémique. Il faut prendre en compte les conséquences d'une action sur de nombreux acteurs liés par des interactions. Les systèmes ne sont pas linéaires, il existe des effets de seuil, des effets de décrochage. Les statistiques associées sont très complexes.

- ⇒ Dans ce contexte, le mieux serait de chercher un compromis plutôt qu'un effet maximal le plus rapidement possible, mais notre culture nous oriente rarement en ce sens.

- Il revient aussi sur plusieurs éléments qui font consensus au niveau scientifique :

- L'importance des continuités écologiques : ce n'est pas juste une vue de l'esprit, de nombreux résultats scientifiques sont à la base de cette recommandation.

- Les structures en mosaïque permettent de mieux résister aux perturbations telles que la sècheresse. Elle sont aussi plus productives. Ces résultats vont dans le sens d'inciter à l'hétérogénéité spatiale, et à éviter d'avoir la même couverture végétale partout.

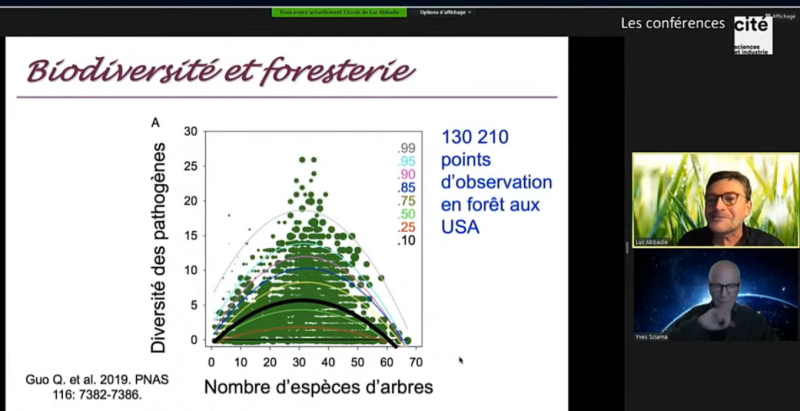

- Les liens entre biodiversité, productivité et résistance aux perturbations sont maintenant avérés pour les plantes herbacées, et cela en prend le même chemin pour la forêt.

- Des perturbations résiduelles peuvent être positives pour la biodiversité lorsqu'elles restent à un niveau intermédiaire (ni trop grandes, ni trop faibles). Par exemple : la crue d'une rivière.

- Le constat actuel avec l'agriculture, tout pays confondu est le suivant : plus la taille du champ avec la même espèce est grande, plus on a de ravageurs et plus on met de pesticides.

⇒ Pour une meilleure résistance aux pathogènes, aux ravageurs, mais aussi pour une meilleure productivité en minimisant les intrants nécessaires : la diversification est la piste la plus sérieuse : maximiser la diversité des espèces et la diversité génétique au sein de chaque espèce.

⇒ Les forêts sont présentées comme source de solution, mais les expérimentations sont lourdes et demandent du temps.

- Des évolutions ont eu lieu avec la notion de services écosystémiques et la mise en place réglementaire de la séquence ERC : Eviter, Réduire et Compenser les dommages faits aux écosystèmes.

- La notion de service écosystémique admet la dépendance de l'humanité aux fonctions écologiques (support de vie, régulation du climat, de l'érosion, approvisionnement, loisir, …). Il est maintenant formalisé et reconnu que nos possibilités d'agir et nos choix en dépendent. Cependant, une approche trop figée et utilitariste peut nous faire passer à côté d'éléments importants qui n'ont pas éveillé l'attention à un instant t et pourraient se révéler importants plus tard.

- Le principe des compensations est un fort moteur qui amène à la mise en place de nombreuses actions de restaurations d'écosystèmes. Cependant, comme la possibilité de compenser est offerte, certains acteurs ayant les moyens peuvent se permettre de détruire plus. De plus, les équivalences ne sont pas estimées de manière approfondie, c'est souvent l'indicateur de surface qui est utilisé uniquement. Cela fait que l'on est en général loin du compte au niveau du système restauré, surtout qu'il est actuellement possible de détruire plus de surface que l'on n'en restaure. En général, toute l'attention est portée à quelques espèces emblématiques, mais le reste de la communauté qui habitait l'écosystème n'est même pas évalué.

- ⇒ Il serait donc intéressant de construire une approche quantitative de l'équivalence, par exemple en quantifiant la connectivité des milieux, la vitesse de dispersion des espèces. Il serait important de prendre en compte le temps qui sera nécessaire pour le nouveau système pour être pleinement fonctionnel. Ce “retard” avant que la compensation soit effective devrait être intégré dans la facture.

- Pour le conférencier, les travaux d'écologie scientifique restent encore trop peu connus et trop peu utilisés. Il existerait une forme d'inculture associée à un déficit de formation dans le domaine. La France aurait sur le sujet un retard au démarrage et une vision de l'écologie passéiste.

Émission sur le "tiers secteur de la recherche" proposée par Grand Labo

Ce mardi 24 Novembre, une émission proposée par Grand Labo aborde le sujet de la recherche participative, aussi appelée “tiers secteur de la recherche” avec plusieurs invités. Voici le lien vers l'article résumé et donnant aussi accès à la vidéo : Tiers secteur de la recherche : quelle reconnaissance ? Je vous partage ce que j'en ai retenu de mon côté ci-dessous.

Malgré le fait que je m'intéresse depuis plusieurs années au sujet, je découvre encore régulièrement de nouveaux acteurs. Ici c'est l'association ALLISS qui organise le 30 novembre et le 1er décembre le lancement des assises du tiers secteur de la recherche (événement à distance, il est possible de s'y inscrire gratuitement). Cette structure travaille à faire évoluer les politiques publiques pour une meilleure reconnaissance de ce “tiers secteur”.

Je retiens aussi une intervention de la représentante de SoSciences, entreprise qui pousse à une recherche-innovation plus responsable. Elle regrette que les chargés de mission en valorisation présents dans les institutions académiques soutiennent beaucoup le côté “start-up” avec volonté de création de richesses, et bien peu le côté innovation sociale et environnementale (qui ne permettent pas forcément de croissance à 2 chiffres). Elle évoque aussi les difficultés de la co-élaboration. Il est important pour elle de se regrouper dès le départ, au moment de définir la question. L'erreur qui est souvent faite est d'arriver avec une question déjà choisie, comme si tout était fait d'avance. Il semble difficile pour les chercheurs de se décentrer assez pour permettre l'inclusion des citoyens. Cela rejoint l'intervention ensuite de la représentante de la coopérative Tetris. Elle évoque une asymétrie des attentes entre les chercheurs et les citoyens qui aimeraient pouvoir passer plus vite à l'action.

La question de la légitimité, des statuts de chacun est aussi abordée. Les problèmes sembleraient surtout venir :

- des chercheurs et techniciens des collectivités qui se montreraient parfois méfiants,

- des chercheurs travaillant dans les institutions telles que le CNRS, qui incorporent en eux l'histoire et les valeurs de cette institution et se sentent la représenter.

Les FabLabs sont ensuite évoqués comme des lieux de médiation pouvant accueillir les nombreuses personnes ayant une culture scientifique avec la massification de l'enseignement supérieur. Cette observation rejoint celle du représentant de l'associationJust One Giant Lab qui évoque les chiffres suivants :

- 1 personne sur 10 aurait reçu une formation scientifique

- 1 personne sur 1000 contribuerait à la recherche scientifique

JOGL soutient une approche communautaire, open source, pour la recherche et l'innovation, à l'image de ce qui existe pour les logiciels libres.

La contestation de la notion d'excellence a aussi été mentionnée. Cette façon de juger en prenant des indicateurs comme l'Impact Factor aurait colonisé le milieu suite à des rapports de force au sein même du monde académique. Elle aurait pris le pas sur la notion de pertinence.

Enfin, une remarque intéressante à la fin de l'émission que je souhaite mettre en avant est celle que la société n'arrive pas actuellement à assimiler, à digérer tout le travail de recherche réalisé et les nombreuses connaissances produites. Cette course après le nouveau peut poser souci en elle-même et amener vers une sorte d'innovation creuse.

Personnellement, cela me conduit à assumer encore mieux le fait de prendre le temps nécessaire à faire des travaux inclusifs, à la pertinence et à la méthode bien réfléchis. Cela m'incite aussi à mieux valoriser les travaux et ressources qui existent déjà pour mettre en place des actions. Plutôt que de rejoindre la course aux résultats et aux publications, je suis contente de pouvoir prendre le temps de m'épanouir au sein du Laboratoire Sauvage. J'espère que le modèle de chercheur-animateur que l'on tente de développer pourra répondre à certains problèmes évoqués dans cette émission.